Blogbeitrag

SEO

Julien

Moritz

veröffentlicht am:

13.02.2026

Content gezielt für Prompts optimieren mit dem Query Fan-Out Prinzip

Inhaltsverzeichnis

Large Language Models (LLMs) wie ChatGPT, Claude oder Gemini verändern gerade grundlegend, wie Inhalte gefunden, bewertet und genutzt werden. Sichtbarkeit entsteht nicht mehr nur über klassische Suchanfragen, sondern zunehmend über Prompts, die Nutzer*innen in KI-Systeme eingeben.

Ein aktuell häufig genanntes Prinzip, um den eigenen Content dahingehend zu optimieren, ist das sogenannte Query Fan-Out Prinzip. Doch was bedeutet das speziell für deinen Content? In diesem Artikel erfährst du, wie ChatGPT & Co. Anfragen im Hintergrund zerlegen und wie du deinen Content so aufbauen kannst, dass er für LLMs relevant, verständlich und zitierfähig ist.

Das Wichtigste in Kürze

LLMs erzeugen aus einem Prompt mehrere Suchanfragen gleichzeitig (Query Fan-Out).

Diese Queries laufen oft parallel auf Deutsch und Englisch.

Inhalte werden anhand von Themen, Entitäten, Begriffen und Synonymen bewertet.

In wenigen Schritten kannst du selbst analysieren, welche Queries ChatGPT nutzt. Wir zeigen dir hier, wie es geht.

Daraus lassen sich konkrete Anforderungen für deinen Content-Aufbau ableiten.

Was ist Query Fan-Out?

Query Fan-Out beschreibt den Prozess, bei dem ein LLM aus einem einzelnen Prompt mehrere Unterfragen erzeugt. Ein Prompt wird also in mehrere Anfragen aufgefächert. Diese Vielzahl an Anfragen nennt man Fan-Out, weil sich eine Anfrage wie ein Fächer in viele einzelne Queries aufteilt. Im Hintergrund schickt das System also simultan verschiedene Suchanfragen an den Index (z. B. Bing oder Google). Erst aus der Synthese der ausgewählten Ergebnisse baut die KI die finale Antwort zusammen.

Wie man dies ganz einfach selbst für einen Prompt untersucht, sehen wir uns in einer Schritt-für-Schritt Anleitung an.

Warum ist Query Fan-Out so wichtig?

Dein Content hat das Ziel, gefunden zu werden. Heute werden allerdings immer häufiger Large Language Models genutzt. Dadurch ändern sich die Anforderungen an deinen Content, damit er weiterhin in den Google Suchergebnissen auftaucht aber auch von möglichst vielen LLMs zur Antwortgenerierung genutzt wird.

Je besser deine Inhalte zu den erzeugten Queries passen, desto wahrscheinlicher wird er von LLMs auch tatsächlich als Quelle verwendet.

Schritt-für-Schritt Anleitung: Welche Queries werden von ChatGPT erstellt?

Anhand eines Beispiel-Prompts in ChatGPT lässt sich sehr gut erkennen, wie diese Queries aussehen. Das kannst du ganz einfach für deine eigenen Prompts nachmachen und dahingehend deinen Content optimieren.

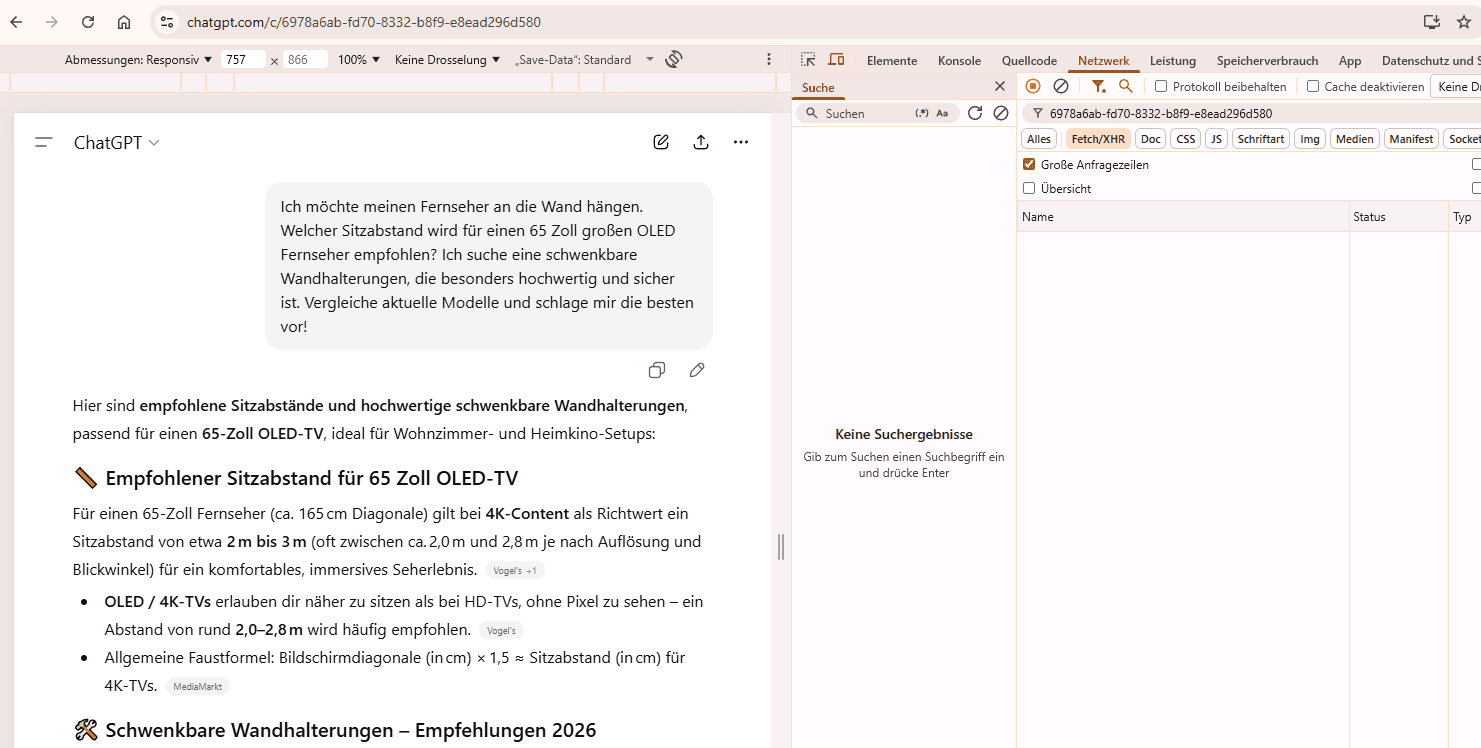

Schritt 1: Entwicklertools öffnen

Öffne ChatGPT im Browser

Gib einen Prompt ein und sende ihn ab

Rechtsklick irgendwo im Interface

„Untersuchen“ auswählen

Schritt 2: Netzwerk-Tab filtern & Chat-ID suchen

Wechsle in den Tab „Netzwerk“

Filtere nach Fetch / XHR

Kopiere die Chat-ID aus dem letzten Teil der URL

Füge sie in das Suchfeld ein

Lade die Seite neu

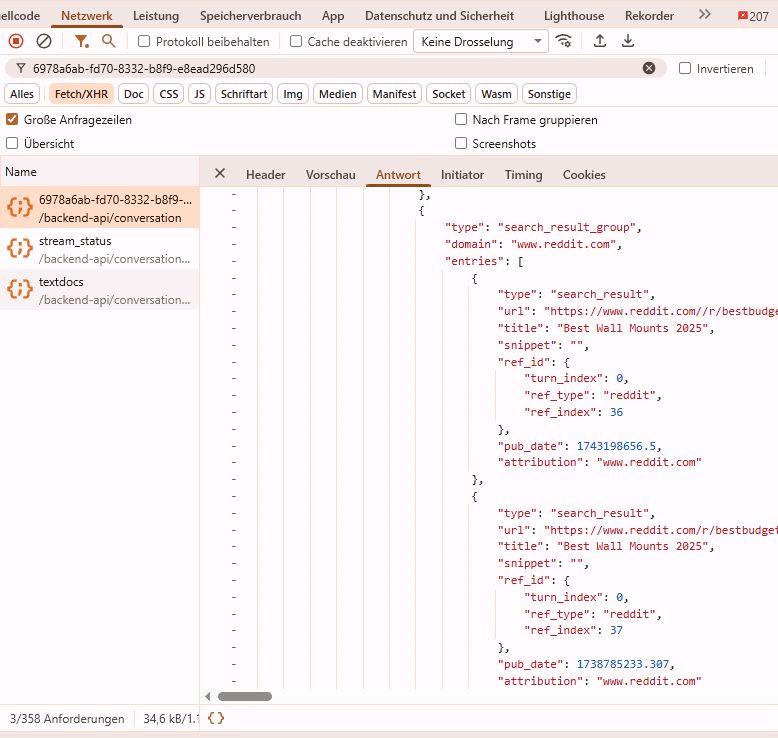

Schritt 3: Netzwerk-Request auswählen

Klicke auf den Netzwerk-Request mit der Chat-ID im Namen

Wechsle in den Reiter „Antwort“

Schritt 4: Queries finden

Suche nach dem Begriff „queries“

Nun siehst du konkrete Suchanfragen, die ChatGPT für die Websuche nutzt

Meistens auf Deutsch und Englisch

Schritt 5: Auswertung der Anfragen

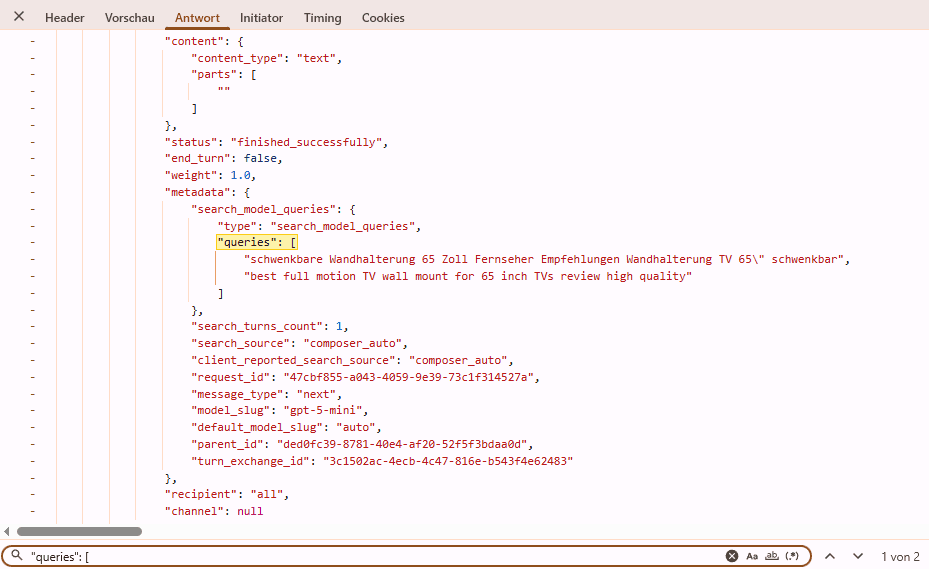

Folgender Prompt wurde eingegeben:

“Ich möchte meinen Fernseher an die Wand hängen. Welcher Sitzabstand wird für einen 65 Zoll großen OLED Fernseher empfohlen? Ich suche eine schwenkbare Wandhalterung, die besonders hochwertig und sicher ist. Vergleiche aktuelle Modelle und schlage mir die besten vor!”

ChatGPT nutzt zwei Sub-Queries in der Websuche, um passende Inhalte zu finden:

1. DE: “schwenkbare Wandhalterung 65 Zoll Fernseher Empfehlungen Wandhalterung TV 65\" schwenkbar”

1. EN: “best full motion TV wall mount for 65 inch TVs review high quality”

2. DE: “Empfohlener Sitzabstand 65 Zoll Fernseher Abstand OLED TV Sitzabstand”

2. EN: “what is recommended viewing distance for 65 inch TV”

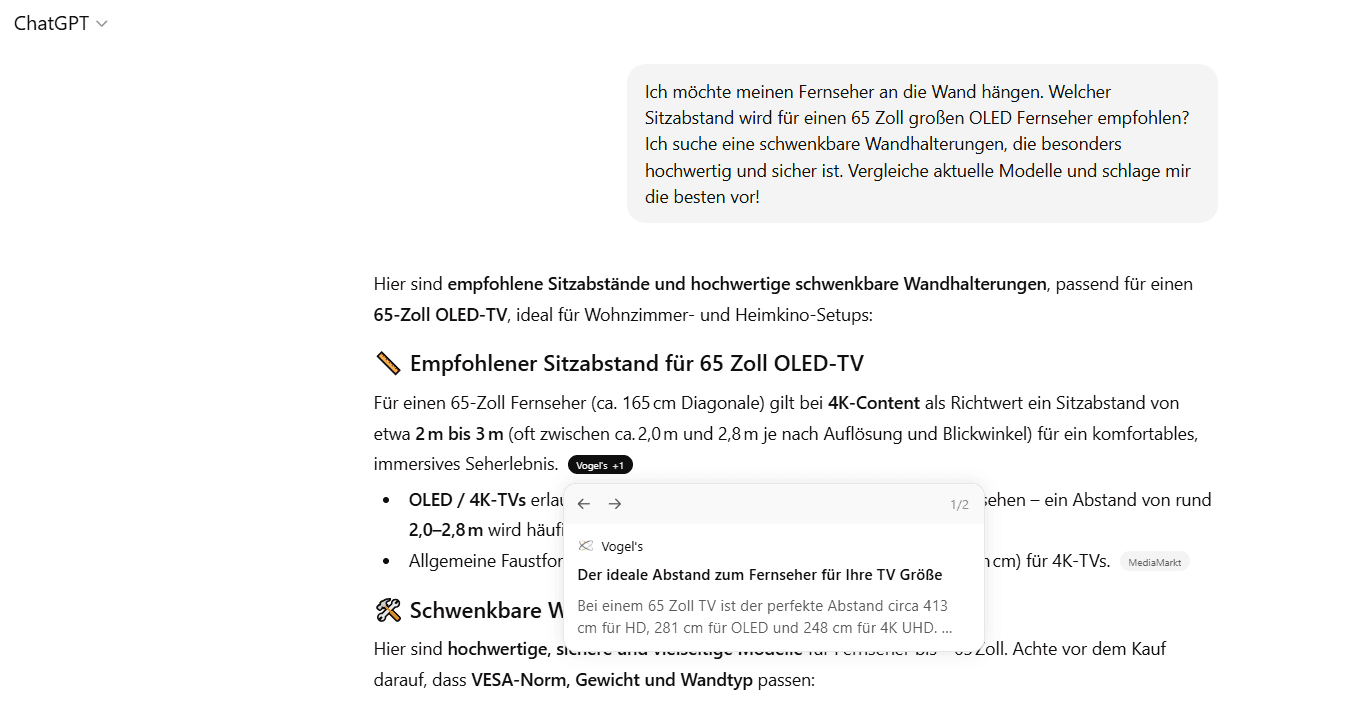

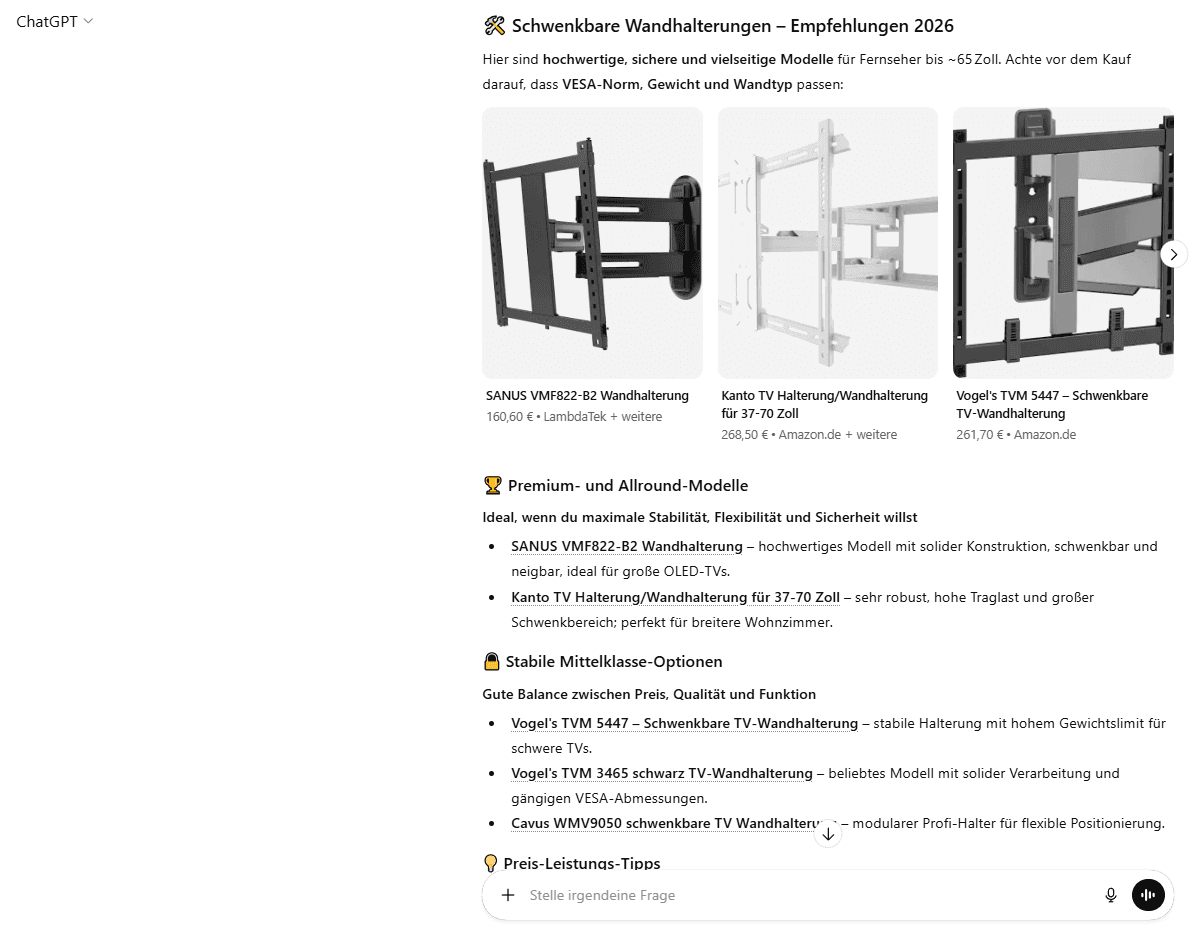

Aus diesen Anfragen sucht ChatGPT nach passenden Quellen und generiert anschließend folgende Antwort, mit Quellenangabe:

Nun solltest du dir die Queries und auch die genutzten Quellen genau anschauen. Welche Content-Typen werden zitiert?

Das genutzte Beispiel zeigt klar, dass es ein Informations-Cluster und ein Vergleichs-Cluster gibt. Es werden unterschiedliche Quellen für diese Cluster genutzt. Um für diesen Prompt optimal gefunden zu werden, benötigst du auf der einen Seite einen informativen Artikel zum Thema “Empfohlener Sitzabstand zum Fernseher”. Aus der Anfrage von ChatGPT lässt sich ableiten, dass die Unterthemen: TV-Größe in Zoll und Display-Arten (z.B. OLED) behandelt werden sollten. Außerdem sollte das Synonym TV Sitzabstand im Content vorkommen, am besten in einer H2.

Die Produkt-Auswahl stammt von anderen Artikeln. Demnach sollten deine Produkte in möglichst vielen Vergleichsartikeln (auf externen Websites) zum Thema “Beste TV-Wandhalterung” vorkommen, damit sie hier präsentiert werden können. Zusätzlich greift ChatGPT auf die Websites der Hersteller zu. Mit dem eigenen Content auf Produkt- und Kategorieseiten können die Antworten von LLMs beeinflusst werden. Überlege dir also klar, was dein Produkt oder deine Dienstleistung ausmacht und wie du dich von Mitbewerbern abhebst. Denn genau diese Vorteile können Nutzer*innen aus dem KI-Chat auf deine eigene Website bringen.

Außerdem kann es auch von Vorteil sein, eigene Vergleichsartikel zu veröffentlichen. Darin solltest du natürlich deine eigene Brand stark präsentieren, aber auch Mitbewerber und ihre Vorteile erwähnen.

LLMs wissen, dass die Informationsdichte im englischsprachigen Netz oft höher ist. Eigene Inhalte zu übersetzen kann somit von großem Vorteil sein und für eine höhere Sichtbarkeit bei ChatGPT und Co. Sorgen.

Strategien zur Optimierung für das Query Fan-Out Prinzip

Was bedeutet das Query Fan-Out Prinzip für den eigenen Content? Du brauchst eine SEO-Strategie, die auch im Zeitalter von generativer KI funktioniert. Dafür haben wir fünf Tipps, die du direkt umsetzen kannst.

1. Ganzheitliche Themencluster statt Keyword-Fokus

Das Google Query Fan-Out Verhalten zeigt, dass Themen in ihrer Gesamtheit erfassen wollen. LLMs teilen einen Prompt in mehrere thematische Cluster mit unterschiedlichem Intent auf, etwa Informations-, Vergleichs- oder Produkt-Queries.

Informativer Content sollte ganzheitlich aufgebaut sein. Inhalte sollten nicht nur „Was“-Frage beantworten, sondern auch das „Wie“, „Warum“ und „Was sind die Alternativen?“. Nutze dabei gezielt Synonyme und verwandte Entitäten. Wenn du über „TV-Wandhalterungen“ schreibst, müssen z.B. auch Begriffe wie „VESA“, „Schwenkbar“ und „OLED-Fernseher“ fallen.

2. Direkte Antworten

Schreibe präzise Definitionen und direkte Antworten auf Nutzer*innenfragen an den Anfang deiner Absätze. Eine KI, die eine schnelle Antwort auf eine Sub-Query sucht, zitiert eher den Text, der eine klare Antwort liefert: „Der ideale Sitzabstand für einen 65 Zoll OLED-TV beträgt etwa 2,50 bis 2,80 Meter.“ Vermeide dabei unnötige Füllsätze, nur um Keywords einzubinden.

Weiterführende und umfangreiche Informationen unter Berücksichtigung sekundärer Keywords kannst du danach platzieren.

3. Strukturierte Daten

LLMs arbeiten ressourcensparend und lieben Struktur. Wenn eine KI einen Preisvergleich oder eine technische Analyse durchführt, greift sie bevorzugt auf Daten in Schema.org ausgezeichneten Informationen zurück. Verwende Strukturiere Daten im Format JSON-LD, um beispielsweise Produkte, FAQs und Rezensionen maschinenlesbar zu machen.

4. International sichtbaren Content mitdenken

Oft generieren Large Language Models automatisch englischsprachige Queries, selbst wenn Prompts auf Deutsch geschrieben werden. Daher wird es umso wichtiger, international sichtbaren Content aufzubauen, selbst wenn die eigene Zielgruppe deutschsprachig ist. Du solltest deine Kerninhalte auch in englischer Sprache zur Verfügung stellen.

5. “Externe” Sichtbarkeit aufbauen

Transaktionale Anfragen, wie “Bestes Preis-Leistungs-Verhältnis TV-Wandhalterung 2026”, werden mithilfe von Vergleichs-Content und Nutzer*innen-Rezensionen beantwortet. Wer mit seiner Marke in LLMs sichtbar sein will, muss sich eine Bekanntheit aufbauen. Content-Partnerschaften mit Magazinen oder Kooperationen mit Influencern, die unabhängige Berichte und Produktvergleiche veröffentlichen, sind ein großer Hebel. Es geht nicht mehr nur im klassische Backlinks, die für Autorität sorgen, sondern um Nennungen der Marke im relevanten Kontext auf möglichst vielen Plattformen. Das können eigene Artikel von Magazinen, Mitbewerbern, Online-Händlern aber auch UGC-Content auf YouTube, Reddit und Co. sein.

Fazit: SEO & GEO vereint

Query Fan-Out macht sichtbar, wie LLMs Inhalte finden und bewerten. Wenn du deinen Content so aufbaust, dass er mehrere Fragen gleichzeitig beantwortet, thematisch vollständig ist und relevante Entitäten sowie Synonyme berücksichtigt, optimierst du nicht nur für klassische Suchmaschinen, sondern gezielt für KI-Systeme. Genau dort entsteht aktuell eine neue Form von Sichtbarkeit. Die Optimierung für das Query Fan-Out Prinzip ist kein „Nice-to-have“ mehr, sondern das neue Fundament für digitale Sichtbarkeit. Indem du verstehst, wie LLMs Anfragen zerlegen, kannst du Inhalte erstellen, die nicht nur gefunden, sondern als vertrauenswürdige Quelle zitiert werden.

Wenn du dabei Unterstützung brauchst oder deinen Content gezielt für LLMs optimieren möchtest, kann dich unser SEO/GEO-Team gerne beraten. Kontaktiere uns jetzt!

Julien

Moritz

Julien Moritz bringt seit Oktober 2023 frischen Wind in das SEO Team der internetwarriors. Mit seinem großen Interesse für Online Marketing und seiner Leidenschaft für SEO Strategien unterstützt er Unternehmen dabei, ihre digitale Präsenz zu verbessern. Seine zielstrebige und lösungsorientierte Arbeitsweise ermöglicht es den Kunden der internetwarriors ihre Ziele zu erreichen.

Kommentare zum Beitrag

noch keine Kommentare

Schreibe einen Kommentar

Deine E-Mail-Adresse wird nicht veröffentlicht. Erforderliche Felder sind mit * markiert